Anúncios

A inteligência artificial redefine nossa relação com o digital. Ela tanto gera conteúdo hiper-realista quanto se torna um guardião contra abusos. Esta tecnologia é o cerne de uma nova era para a segurança online. A privacidade digital nunca foi tão desafiada. Com ferramentas generativas, a criação de deepfakes e a manipulação de mídias se tornaram acessíveis. Isso amplia os riscos para indivíduos e empresas. Recentemente, um caso real chocou o setor. Uma startup do ramo sofreu um vazamento massivo de dados.

O incidente expôs milhares de imagens e vídeos pessoais de pessoas, servindo como um alerta severo. Diante disso, surgem soluções que usam a IA para detectar esses vazamentos. No entanto, é uma ferramenta de dupla face. Ela pode proteger, mas também foi a causa da vulnerabilidade inicial. Este artigo explora esse cenário complexo. Vamos analisar incidentes específicos, métodos de detecção e sinais de falsificação. Por fim, discutiremos estratégias para defender sua autenticidade e privacidade no futuro.

Anúncios

O Incidente que Expôs a Fragilidade da Ética na IA

A descoberta de uma falha catastrófica em sistemas de uma startup revelou brechas éticas alarmantes. Este evento serviu como um marco, mostrando como a busca por inovação pode negligenciar a proteção de dados.

Em outubro, o pesquisador de segurança Jeremiah Fowler encontrou um banco desprotegido. Ele estava vinculado a aplicativos populares de criação de conteúdo visual.

Anúncios

O caso envolvia mais de um milhão de imagens e vídeos. Eles ficaram abertamente acessíveis na rede mundial por um período significativo.

Este não foi um problema isolado. Ele reflete uma apatia mais ampla no setor de startups de inteligência artificial em relação à confiança do usuário.

Muitas empresas priorizam o lançamento rápido de ferramentas. Elas frequentemente deixam a segurança e a ética em segundo plano.

O incidente ocorre em um contexto global preocupante. Relatórios indicam que o uso criminoso dessa tecnologia para criar material de abuso mais que dobrou.

Especialmente nos Estados Unidos, autoridades estão em alerta. A facilidade de acesso a ferramentas poderosas amplifica os riscos.

Este caso específico expõe a necessidade urgente de mudanças. São necessárias regulamentações mais rígidas para quem opera com dados sensíveis.

Padrões claros de segurança e auditorias independentes são essenciais. Sem eles, a inovação continuará a colidir com a proteção das pessoas.

A lição é clara: a ética não pode ser um complemento. Ela deve ser a base de qualquer desenvolvimento tecnológico significativo.

O Caso DreamX: Um Banco de Dados de 1 Milhão de Imagens Vazado

Jeremiah Fowler, pesquisador de segurança, encontrou um repositório desprotegido contendo material sensível de milhões de usuários. Esta descoberta expôs falhas graves em serviços populares de edição visual.

O que foi descoberto pelo pesquisador de segurança

O especialista analisou plataformas como MagicEdit e DreamPal. Ambas eram operadas pela startup DreamX e compartilhavam a mesma vulnerabilidade.

Um banco de dados com 1.099.985 registros estava acessível sem qualquer proteção. O conteúdo incluía tanto imagens sintéticas quanto fotos reais de pessoas.

Muitos arquivos foram enviados pelos próprios usuários para serem alterados. A maioria absoluta do material tinha natureza pornográfica explícita.

Esta exposição massiva revelou como ferramentas de edição podem ser exploradas. A geração imagens por meio de algoritmos criou um volume alarmante de registros.

A natureza explícita do conteúdo e os riscos para menores

O caso ganhou contornos ainda mais sombrios com a análise dos detalhes. Entre os milhões de arquivos, havia representações preocupantes.

Deepfakes com rostos infantis e simulações de abuso foram identificados. Este conteúdo gerado artificialmente amplifica riscos reais de exploração.

Nos Estados Unidos, autoridades já monitoram o aumento desse tipo de material. A facilidade de acesso a ferramentas poderosas preocupa especialistas.

Fowler alertou que aplicativos de nudez podem se tornar armas para extorsão. O assédio digital encontra terreno fértil nesse ecossistema vulnerável.

A resposta da startup e a suspensão dos aplicativos

A DreamX, empresa responsável pelos serviços, reagiu às denúncias. Ela afirmou levar as preocupações “extremamente a sério” e tomou medidas imediatas.

O acesso ao banco de dados foi encerrado rapidamente após a notificação. Uma investigação interna com assessoria jurídica foi iniciada.

Entretanto, a questão da moderação prévia permanece. A startup alegava usar a API de Moderação da OpenAI para filtrar conteúdo.

A exposição massiva ocorreu mesmo com esse sistema ativo. Isso questiona a eficácia dos controles implementados pela empresa.

A Google confirmou ter suspendido aplicativos da desenvolvedora anteriormente. Violações de políticas nas lojas digitais já haviam sido identificadas.

Os produtos MagicEdit e DreamPal foram removidos das principais redes de distribuição. A Apple também seguiu o mesmo caminho de restrição.

Este caso serve como alerta sobre a responsabilidade das plataformas. A proteção de dados sensíveis exige compromisso genuíno com a ética digital.

Deepfakes e Nudificação: O Lado Sombrio da IA Generativa

Deepfakes e serviços de nudificação emergiram como ferramentas de duplo propósito no cenário digital atual. Eles permitem a substituição de rostos em corpos nus ou a criação de gravações hiper-realistas falsas.

Essa tecnologia transforma conteúdo comum em material explícito sem consentimento. A manipulação visual alcançou níveis alarmantes de realismo.

Originalmente desenvolvidas para entretenimento, essas ferramentas são facilmente desviadas. Elas servem agora para assédio, difamação e pornografia de vingança.

O ecossistema de serviços de “nudificação” é usado por milhões de pessoas. Infelizmente, ele tem sido explorado para criar imagens explícitas maliciosas.

O alvo predominante são mulheres. Suas fotografias são roubadas de redes sociais e transformadas sem autorização.

Esse fenômeno representa uma violação grave da privacidade. A maioria das vítimas descobre o abuso apenas quando o conteúdo já circula amplamente.

O processo técnico por trás dessa geração envolve modelos de inteligência artificial complexos. Esses sistemas são treinados em grandes conjuntos de dados visuais.

Os algoritmos aprendem padrões faciais e corporais detalhados. Essa capacidade permite recriar rostos com precisão assustadora em contextos falsos.

O exemplo da DreamX ilustra como plataformas se tornam vetores de violação. A empresa oferecia serviços que facilitavam a criação desse material sensível.

Milhares de imagens foram processadas sem controles adequados. A exposição do banco de dados revelou a escala do problema.

Nos Estados Unidos, autoridades monitoram o crescimento dessa ameaça. A legislação ainda corre atrás dos avanços tecnológicos.

O impacto psicológico nas vítimas é devastador. Pessoas enfrentam ansiedade, depressão e isolamento social após serem alvo.

A reputação profissional e pessoal pode ser destruída em horas. A sensação de violação perdura muito após a remoção do material.

Remover deepfakes da internet é uma batalha quase impossível. O conteúdo se replica rapidamente através de múltiplas plataformas.

Cada compartilhamento amplifica o dano causado à vítima. A sensação de perda de controle sobre a própria imagem é profunda.

Este meio digital criou novas formas de violência psicológica. A tecnologia que prometia criatividade tornou-se instrumento de opressão.

A sociedade precisa desenvolver respostas urgentes para esse desafio. A proteção da dignidade humana deve guiar o desenvolvimento futuro dos algoritmos.

Como a IA Pode Revelar se Seu Conteúdo foi Vazado?

Na contramão dos riscos, a tecnologia que cria falsificações também oferece meios para combatê-las. Esta dualidade define o cenário atual da segurança digital.

O uso de ferramentas que detectam conteúdos sintéticos cresce constantemente. Elas verificam a autenticidade de vídeos, arquivos de áudio ou fotografias.

Esses sistemas analisam padrões estatísticos invisíveis ao olho humano. Eles buscam assinaturas digitais deixadas pelos algoritmos geradores.

Metadados e imperfeições mínimas são examinados com precisão. A detecção compara o material suspeito com bancos de referência.

Verificadores de fatos empregam soluções como o InVid e o SynthID do Google. Estas ferramentas ajudam a identificar manipulações em imagens e gravações.

Elas funcionam como detetives digitais especializados. Sua análise revela inconsistências em texturas, iluminação e movimentos.

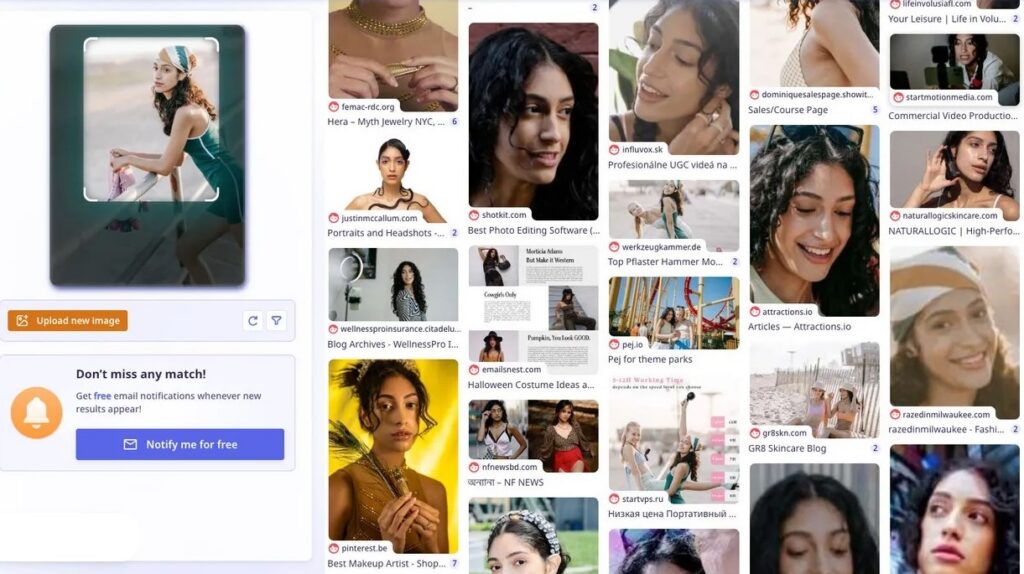

Para indivíduos, existem serviços de monitoramento baseados em inteligência artificial. Eles rastreiam a web em busca de dados pessoais expostos.

Em teoria, é possível descobrir se suas fotografias ou vídeos aparecem em repositórios vazados. A tecnologia escaneia sites não autorizados continuamente.

Ela usa reconhecimento facial e comparação de imagens para encontrar correspondências. Alertas são enviados quando um match é identificado.

Esta abordagem representa uma aplicação defensiva da mesma inteligência. O algoritmo que antes ameaçava agora atua como guardião.

No entanto, essas soluções possuem limitações significativas. Elas não devem ser vistas como respostas infalíveis para o problema.

A precisão varia conforme a qualidade do material original e das manipulações. Falsos negativos e falsos positivos ainda são comuns.

A próxima seção explorará por que chatbots comuns falham nesta tarefa. A confiabilidade dos detectores atuais merece análise cuidadosa.

Os Limites dos Detectores de IA: Por que Chatbots não São Confiáveis

Nem todas as ferramentas de inteligência artificial são criadas para a mesma finalidade. Muitas pessoas cometem o erro de acreditar que qualquer sistema pode verificar a autenticidade de conteúdo digital.

Esta confusão leva a decisões perigosas. Especialistas alertam sobre os riscos de depender de soluções inadequadas para problemas complexos.

Chatbots como Gemini não foram feitos para essa tarefa

Sistemas como Gemini e ChatGPT possuem um propósito claro. Eles foram projetados para geração de texto, não para análise forense de mídias.

Esses modelos operam com base em probabilidades estatísticas. Eles predizem a próxima palavra mais plausível em uma sequência.

Um conceito crucial explica essa limitação: a falta de um “modelo de mundo”. Diferente dos humanos, os LLMs não raciocinam sobre o significado real do material.

Eles não compreendem se um vídeo representa eventos reais ou fabricados. Sua resposta será sempre uma construção linguística probabilística.

O problema dos falsos positivos e da taxa de erro

Testes de laboratório revelam números preocupantes. Detectores especializados em vídeos falsos acertam cerca de 85% das vezes.

Esta taxa significa um erro de aproximadamente 15%. Para questões de segurança pessoal, essa margem é inaceitavelmente alta.

Os erros se manifestam de duas formas principais. Falsos positivos classificam conteúdo legítimo como sintético.

Falsos negativos deixam passar manipulaçãoes avançadas. Ambos os problemas geram consequências graves.

Um exemplo didático ilustra bem o caso. Perguntar a um chatbot se algo é falso equivale a um “sorteio das chances”.

O sistema fornecerá uma resposta plausível, mas não fundamentada em análise real. Os resultados não possuem confiabilidade técnica.

A corrida entre geração e detecção de conteúdo sintético

O cenário atual representa uma verdadeira corrida armamentista tecnológica. As ferramentas de criação evoluem mais rápido que as de análise.

Especialistas descrevem esta dinâmica como assimétrica. Cada avanço na detecção é rapidamente superado pela geração.

As imperfeições que antes identificavam falsificações estão desaparecendo. Áudio e vídeos sintéticos alcançam realismo impressionante.

Entretanto, qualquer vantagem dos detectores é temporária. Os criadores ajustam seus algoritmos para eliminar padrões identificáveis.

Esta corrida consome tempo e recursos de ambos os lados. O meio digital se torna um campo de batalha constante.

O exemplo do ministro venezuelano mostra o uso inadequado na prática. Ele utilizou o Gemini para acusar um registro visual sem base técnica.

Esta atitude demonstra compreensão limitada das capacidades reais da tecnologia. Confiar cegamente em resultados automáticos é arriscado.

A conclusão é clara: dependência exclusiva em detectores automáticos é estratégia falha. Principalmente quando se usam ferramentas de propósito geral.

A proteção contra vazamentos e falsificações exige abordagem multifacetada. Soluções técnicas devem ter sido complementadas por verificação humana e procedimentos robustos.

Sinais Visuais: Dicas para Identificar um Vídeo Falso

Identificar falsificações visuais exige atenção a detalhes específicos que revelam a origem sintética do material. Especialistas como o professor Hany Farid, pioneiro em forense digital, desenvolveram métodos práticos para essa análise.

Existem três sinais principais que servem como alerta. Eles envolvem características técnicas observáveis mesmo sem ferramentas especializadas.

Baixa qualidade e compressão como camuflagem

Filmagens borradas ou granuladas devem levantar suspeitas imediatas. A baixa qualidade de imagem muitas vezes é intencional.

Mal-intencionados degradam vídeos falsos propositalmente. Esta compressão excessiva esconde imperfeições deixadas pelos geradores.

Texturas não naturais e movimentos estranhos ficam mascarados pelo ruído visual. O resultado é uma camuflagem eficaz para erros da tecnologia.

Um exemplo real ilustra bem esta tática. O vídeo viral dos coelhos no trampolim usou filmagem noturna de baixa resolução.

Milhões de pessoas foram enganadas pela gravação. O padrão de qualidade inferior é comum em conteúdos sintéticos.

Duração curta e cortes recorrentes

A maioria das produções artificiais atualmente são muito breves. Elas raramente ultrapassam seis a dez segundos de exibição.

Limitações técnicas e custos computacionais explicam esta característica. Gerar sequências mais longas aumenta a probabilidade de falhas visíveis.

Costuras entre clipes diferentes criam cortes recorrentes no material. Estas transições abruptas revelam a junção de múltiplas gerações.

Observar a duração total oferece uma pista valiosa. Vídeos excessivamente curtos merecem verificação adicional.

Inconsistências sutis em texturas, cabelo e movimento

Alguns sinais são mais difíceis de perceber a olho nu. Eles requerem observação atenta de elementos específicos da cena.

A suavidade anormal da pele é um indicador comum. Texturas epidérmicas parecem muito uniformes e sem poros naturais.

Fios de cabelo frequentemente se comportam de forma não física. Eles podem ignorar a gravidade ou apresentar padrões estranhos de movimento.

Roupas e objetos de fundo também revelam inconsistências. Sua movimentação pode não corresponder às leis da física real.

O casal no metrô de Nova York tornou-se um caso emblemático. O vídeo pixelado enganou espectadores com suas falhas sutis.

Micro-movimentos faciais naturais frequentemente estão ausentes. Expressões parecem robóticas ou excessivamente repetitivas.

Especialistas alertam que estes sinais visuais são temporários. As imperfeições mais óbvias devem desaparecer em até dois anos.

A evolução dos algoritmos tornará a detecção visual cada vez mais difícil. Deepfakes futuros apresentarão realismo quase perfeito.

Nos Estados Unidos, pesquisadores já preveem este cenário. A corrida tecnológica exige métodos de verificação constantemente atualizados.

Reconhecer estas características hoje oferece uma vantagem crucial. Esta inteligência prática protege contra enganos imediatos.

Por que Confiar Apenas nos Olhos (ou na IA) é Insuficiente

A ilusão de que podemos confiar plenamente no que vemos ou no que máquinas analisam nos coloca em risco constante. O professor Matthew Stamm alerta com clareza: “Você simplesmente não pode confiar nos seus olhos.” Esta afirmação resume o problema central da era digital atual.

Nossa percepção visual possui limitações intrínsecas. Ela é facilmente enganada por vídeos de baixa qualidade que escondem falhas técnicas.

O cérebro humano tende a preencher lacunas de informação automaticamente. Esta característica nos faz aceitar inconsistências sutis sem questionamento.

As ferramentas de detecção automática, por sua vez, também falham. Como discutido anteriormente, elas possuem taxas de erro significativas que comprometem os resultados.

Estamos diante de uma corrida tecnológica desigual. Os algoritmos geradores evoluem mais rápido que os sistemas de análise.

Qualquer vantagem dos detectores é temporária. Os criadores de conteúdo sintético ajustam seus métodos para eliminar padrões identificáveis.

A solução, portanto, não está em buscar uma “ferramenta mágica” de verificação. Esta questão exige uma mudança profunda em nossa forma de consumir informações.

Pesquisadores especializados utilizam técnicas avançadas de análise forense. Eles observam “pequenos traços estatísticos que os nossos olhos não conseguem ver, como impressões digitais”.

Estas impressões digitais são marcas deixadas pela geração ou modificação de arquivos. Elas residem nos dados de fundo, invisíveis à observação comum.

Apenas equipamentos especializados podem capturar esses sinais. A análise humana direta, por mais treinada, não alcança este nível técnico.

Da mesma forma, sistemas de inteligência artificial de propósito geral falham nesta tarefa. Eles não foram projetados para a minúcia requerida pela forense digital.

O caminho mais seguro combina múltiplas camadas de verificação. Um olhar crítico inicial deve ser complementado por ferramentas auxiliares.

Mais importante ainda é a checagem do contexto e da proveniência do material. De onde veio esta informação? Quem a publicou pela primeira vez?

Muitas pessoas compartilham conteúdo nas redes sem fazer estas perguntas básicas. Esta atitude amplifica a disseminação de falsificações.

Em diversas vezes, um simples questionamento sobre a fonte revela a fraude. A pressa em compartilhar supera o instinto de verificação.

Os erros de julgamento ocorrem quando depositamos confiança exclusiva em um único método. Seja ele a visão humana ou a análise algorítmica.

A verdadeira proteção emerge da convergência de abordagens. Nenhuma ferramenta, sozinha, pode oferecer garantia absoluta.

Esta inteligência coletiva é nossa melhor defesa contra a manipulação digital. Ela reconhece que tanto nossos sentidos quanto as máquinas possuem falhas.

O futuro da autenticidade, como veremos a seguir, depende desta compreensão. Precisamos construir ecossistemas de verificação mais robustos e conscientes.

O Futuro da Autenticidade: Proveniência e Contexto

Proveniência, um termo técnico pouco conhecido, pode se tornar a chave para distinguir realidade de ficção no futuro. Ela representa a origem e o histórico completo de um arquivo digital.

Mike Caulfield, especialista em alfabetização digital, defende uma visão clara. Ele afirma que, a longo prazo, “a proveniência será mais importante que as características superficiais”.

Esta mudança de paradigma redefine nossa abordagem. Em vez de analisar apenas a aparência, investigaremos a trajetória do conteúdo.

Iniciativas tecnológicas emergentes buscam embutir informações diretamente nos arquivos. Watermarks digitais criptográficos são criados no momento da captura por uma câmera.

Estas marcas à prova de violação atestam que uma imagem é original. Elas comprovam que o material não foi gerado por inteligência artificial.

Paradoxalmente, as próprias ferramentas generativas também poderão ser obrigadas a marcar seus conteúdos. Um sistema de rotulagem automática identificaria produções sintéticas.

Esta dupla camada de verificação cria um ecossistema mais transparente. Conteúdos legítimos e artificiais teriam assinaturas digitais distintas.

Podemos comparar essa mudança com a forma como tratamos texto atualmente. Não acreditamos em uma afirmação apenas porque está escrita.

Investigamos a fonte, o autor e o contexto por trás das palavras. Aplicaremos o mesmo rigor crítico aos vídeos e imagens no futuro.

A pergunta crucial sofrerá uma transformação fundamental. Não será mais “Isso parece falso?” mas “De onde isso veio?”.

Quem publicou este material pela primeira vez? Com qual contexto e intenção ele foi compartilhado inicialmente?

Estas questões investigativas formarão a base da verificação futura. A análise técnica complementará, mas não substituirá, a checagem da origem.

Implementar um sistema universal de proveniência representa um desafio colossal. Exige cooperação entre empresas, governos e a sociedade civil.

Padrões técnicos precisam ser desenvolvidos e adotados globalmente. Dispositivos de captura devem incorporar a tecnologia necessária.

Os especialistas reconhecem que esta jornada levará anos. A transição exigirá tempo e investimento significativo.

No entanto, esta abordagem é vista como a grande esperança. Ela supera as limitações dos atuais modelos de detecção visual.

Um exemplo prático ilustra a diferença. Hoje, analisamos a qualidade de um áudio para suspeitar de manipulação.

No futuro, verificaremos os metadados embutidos no arquivo original. Estes detalhes técnicos contarão a história real da criação.

O meio digital precisará desenvolver infraestruturas de confiança. Sistemas de certificação e verificação de origem se tornarão comuns.

Esta visão é compartilhada por diversos especialistas no campo. Eles veem a proveniência como a próxima fronteira na autenticidade digital.

A corrida entre criação e detecção pode encontrar um ponto de equilíbrio. A origem verificável oferece uma base mais sólida que a análise superficial.

O futuro da autenticidade não está apenas na tecnologia. Está na construção de ecossistemas onde a origem seja transparente e verificável.

Protegendo a Privacidade em uma Era de Replicação Digital

Cada usuário precisa adotar estratégias proativas para salvaguardar sua imagem pessoal online. A cautela ao compartilhar fotos é fundamental, especialmente em redes sociais abertas.

Configure ferramentas de privacidade com rigor e revise permissões de aplicativos regularmente. Essas ações limitam o acesso não autorizado aos seus dados visuais.

Desenvolva educação digital para reconhecer sinais de falsificação. Desconfie de conteúdos emocionais com origem duvidosa no contexto das redes.

Exija responsabilidade das empresas de tecnologia. Apoie leis que imponham salvaguardas robustas para a segurança das pessoas.

A proteção eficaz combina consciência individual com avanço técnico. Juntos, podemos construir um ambiente digital mais seguro para todas as imagens.